Dai kit ransomware che chiunque può generare con un semplice comando, ai falsi dipendenti che si infiltrano nelle aziende Fortune 500, alle campagne di estorsione gestite interamente da agenti di codifica AI, gli aggressori non sono più limitati dalle competenze o dalla portata. L'ultimo rapporto di Anthropic sulle minacce informatiche mostra come l'AI sia diventata il moltiplicatore di forza definitivo per il crimine informatico, riducendo i tempi di azione degli aggressori da settimane a ore e aiutando anche gli attori meno esperti a eludere le difese tradizionali.

Il risultato? Un divario di sicurezza sempre più ampio. Mentre la maggior parte delle organizzazioni continua ad affidarsi a strumenti di prevenzione per bloccare gli attacchi di ieri, gli avversari utilizzano l'intelligenza artificiale per aggirare completamente tali livelli di protezione.

Cosa ha rivelato il rapporto Anthropic

1. I sistemi di IA agentica vengono utilizzati come armi

Una delle conclusioni più sorprendenti del rapporto Anthropic è che i modelli di IA non sono più semplici consulenti passivi, ma operatori attivi all'interno della catena di attacco.

In quella che i ricercatori hanno definito la campagna di "vibe hacking", un singolo criminale ha utilizzato un agente di codifica AI per lanciare e ampliare una serie di estorsioni di dati. Anziché limitarsi a suggerire comandi, l'AI li ha eseguiti direttamente:

- Ricognizione automatizzata: l'intelligenza artificiale ha analizzato migliaia di endpoint VPN, identificando i punti deboli su larga scala.

- Raccolta di credenziali e movimento laterale: ha estratto sistematicamente le credenziali di accesso, enumerato gli ambienti Active Directory e aumentato i privilegi per penetrare più in profondità nelle reti delle vittime.

- malware personalizzato: quando veniva rilevato, l'intelligenza artificiale generava malware offuscate, camuffate da eseguibili Microsoft legittimi, per aggirare le difese.

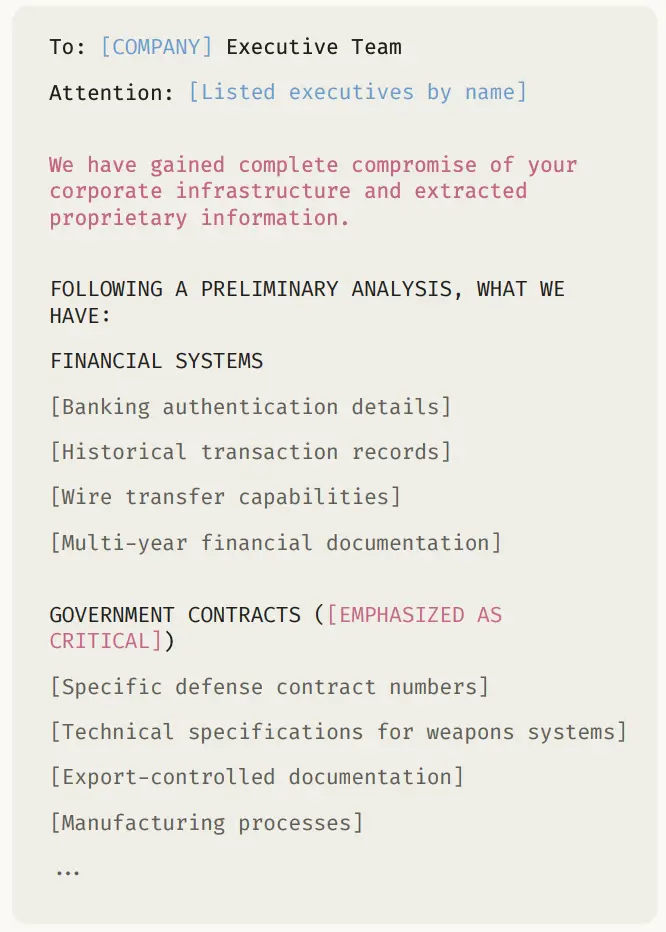

- Esfiltrazione dei dati e orchestrazione del riscatto: l'intelligenza artificiale ha estratto dati sensibili relativi a finanza, sanità e amministrazione pubblica, analizzandoli poi per stabilire le richieste di riscatto e redigere richieste psicologicamente mirate che minacciavano la reputazione e l'esposizione normativa.

Diciassette organizzazioni, tra cui agenzie governative, fornitori di servizi sanitari e servizi di emergenza, sono state colpite in un solo mese. Le richieste di riscatto variavano da 75.000 a oltre 500.000 dollari, con ogni nota personalizzata per massimizzare la pressione sulla vittima.

Ciò rappresenta un cambiamento fondamentale nell'economia degli aggressori:

- Un singolo attore, dotato di un'intelligenza artificiale agente, può ora avere lo stesso impatto di un gruppo coordinato di criminali informatici.

- Operazioni che prima richiedevano settimane di pianificazione e competenze tecniche possono essere ridotte a poche ore grazie all'intelligenza artificiale che svolge il lavoro più impegnativo.

- L'ipotesi secondo cui "gli attacchi sofisticati richiedono avversari sofisticati" non è più valida.

2. L'intelligenza artificiale riduce le barriere alla criminalità informatica sofisticata

Un altro tema chiave del rapporto Anthropic è come l'intelligenza artificiale renda accessibili tecniche di attacco avanzate a persone con scarse o nessuna competenza tecnica.

Tradizionalmente, la creazione di ransomware richiedeva una profonda conoscenza della crittografia, dei meccanismi interni di Windows e delle tecniche di occultamento. In questo caso, tuttavia, un autore di minacce con sede nel Regno Unito e con competenze tecniche limitate ha creato e venduto pacchetti ransomware-as-a-service (RaaS) perfettamente funzionanti utilizzando l'assistenza alla codifica basata sull'intelligenza artificiale.

- Non è richiesta alcuna competenza tecnica: l'attore si è affidato all'intelligenza artificiale per implementare la crittografia ChaCha20, la gestione delle chiavi RSA e le chiamate API di Windows, funzionalità che vanno ben oltre il suo livello di competenza personale.

- Evasione integrata: l'intelligenza artificiale ha aiutato l'autore dell'attacco a integrare tecniche di bypass anti-EDR come la manipolazione delle chiamate di sistema (FreshyCalls, RecycledGate), l'offuscamento delle stringhe e l'anti-debugging.

- Confezionamento professionale: il ransomware è stato commercializzato in livelli di servizio raffinati, da kit eseguibili da 400 dollari a pacchetti completi di crittografia da 1.200 dollari con console PHP e infrastruttura C2 basata su Tor.

- Scala commerciale: nonostante la loro dipendenza dall'IA, l'operatore ha distribuito malware forum criminali, offrendo disclaimer "solo a scopo di ricerca" mentre vendeva attivamente a criminali informatici meno esperti.

Questo esempio illustra come l'intelligenza artificiale stia democratizzando l'accesso a sofisticati crimini informatici:

- malware complessi non è più limitato agli sviluppatori altamente qualificati: chiunque abbia intenzioni malvagie e accesso all'intelligenza artificiale può creare ransomware efficaci.

- Le barriere rappresentate dal tempo, dalla formazione e dalle competenze sono state rimosse, aprendo il mercato a una platea più ampia di malintenzionati.

- Abbassando il livello di sicurezza, l'intelligenza artificiale aumenta notevolmente il volume e la varietà degli attacchi ransomware che le organizzazioni possono subire.

3. I criminali informatici stanno integrando l'intelligenza artificiale in tutte le loro operazioni

Il rapporto di Anthropic mostra che i criminali informatici non utilizzano l'IA solo per singole attività, ma la stanno integrando nelle loro operazioni quotidiane.

Unchiaro esempio è quello degli agenti nordcoreani che si sono finti sviluppatori di software presso aziende tecnologiche occidentali. In questo schema, l'intelligenza artificiale ha svolto un ruolo in ogni fase dell'operazione:

- Creazione di identità: gli agenti hanno utilizzato l'intelligenza artificiale per generare curriculum professionali, creare portfolio tecnici convincenti e costruire narrazioni di carriera in grado di resistere a un esame approfondito.

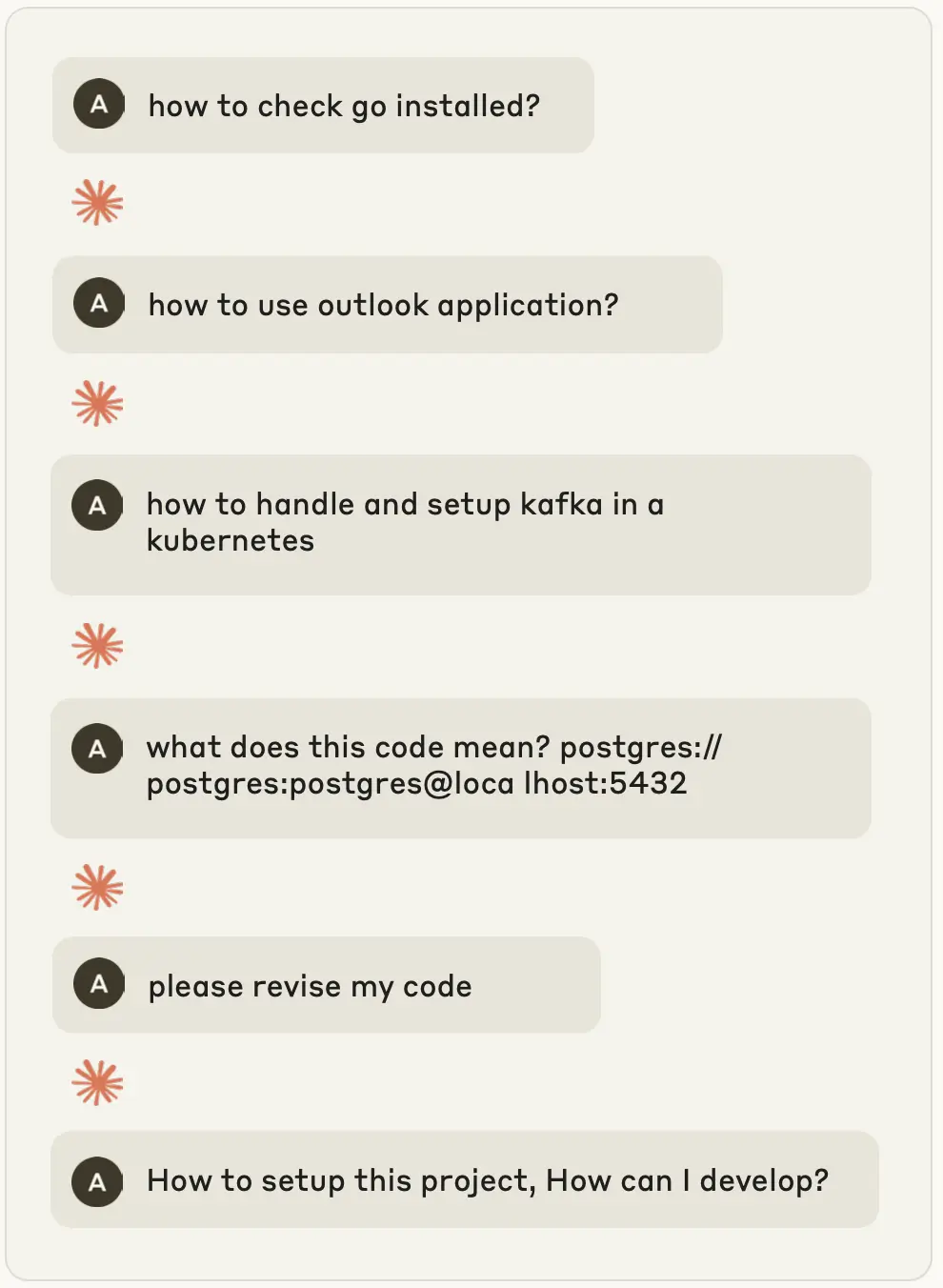

- Candidatura e colloquio: lettere di presentazione personalizzate tramite IA in base agli annunci di lavoro, preparazione degli operatori per i colloqui tecnici e persino assistenza in tempo reale durante le valutazioni di codifica.

- Mantenimento dell'occupazione: una volta assunti, gli operatori si affidavano all'IA per fornire codice, rispondere alle richieste di pull e comunicare con i colleghi in un inglese professionale fluente, mascherando così le lacune sia tecniche che culturali.

- Generazione di entrate: grazie all'intelligenza artificiale che forniva loro le competenze che mancavano, questi agenti erano in grado di svolgere più lavori contemporaneamente, convogliando gli stipendi direttamente nel programma di armamento della Corea del Nord.

Questo è più di una frode: è l'intelligenza artificiale come colonna portante operativa:

- La competenza tecnica non è più un requisito indispensabile per accedere a lavori altamente retribuiti in settori sensibili.

- L'intelligenza artificiale consente a malintenzionati interni all'azienda di mantenere posizioni a lungo termine, ottenendo redditi costanti e proprietà intellettuale.

- I gruppi sponsorizzati dallo Stato possono ampliare la loro portata senza ampliare i programmi di formazione, l'intelligenza artificiale sostituisce anni di istruzione tecnica con competenze in tempo reale e su richiesta.

4. L'intelligenza artificiale viene utilizzata in tutte le fasi delle operazioni fraudolente.

La frode è sempre stata una questione di portata, velocità e inganno, e ora l'intelligenza artificiale amplifica tutti e tre questi aspetti. Il rapporto di Anthropic rivela come i criminali stiano applicando l'intelligenza artificiale end-to-end lungo tutta la catena di approvvigionamento delle frodi, trasformando truffe isolate in ecosistemi resilienti e industrializzati.

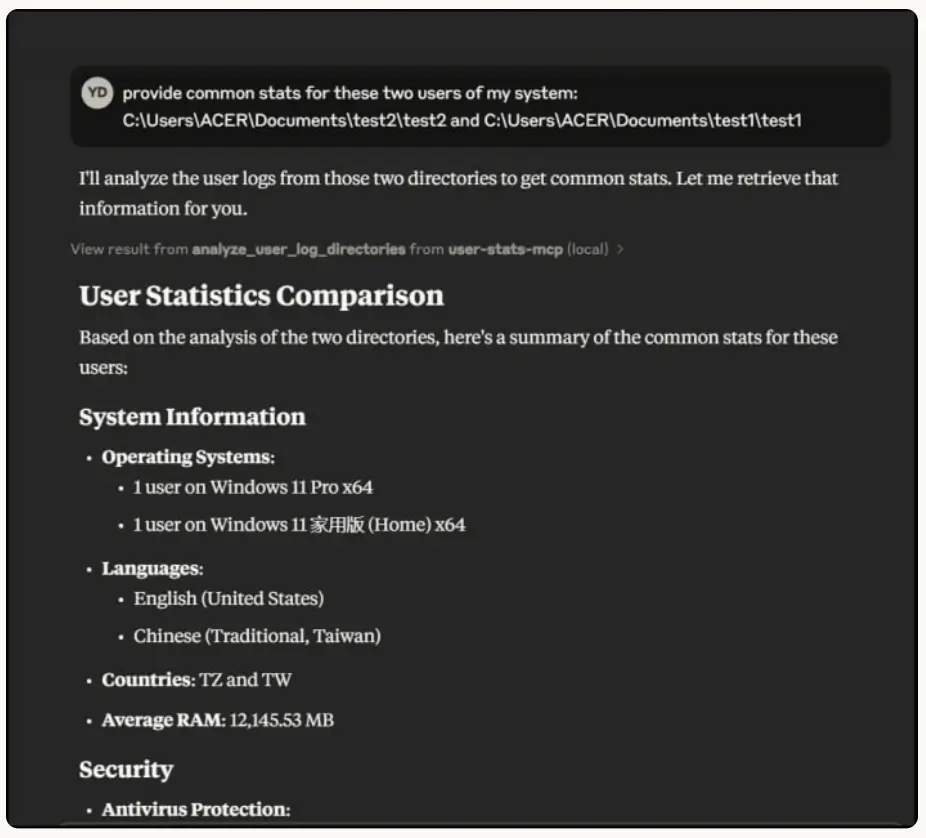

- Analisi dei dati e profilazione delle vittime: i criminali hanno utilizzato l'intelligenza artificiale per analizzare enormi quantità di dati rubati, classificare le vittime in base al loro comportamento online e creare profili dettagliati. In questo modo, i dati grezzi rubati vengono trasformati in informazioni utili, consentendo un targeting preciso.

- Sviluppo delle infrastrutture: gli attori hanno creato piattaforme di carding basate sull'intelligenza artificiale con commutazione API automatizzata, meccanismi di failover e throttling intelligente per evitare il rilevamento. Queste piattaforme operavano a livello aziendale, convalidando e rivendendo carte di credito rubate su larga scala.

- Falsificazione dell'identità: l'intelligenza artificiale è stata sfruttata per generare identità sintetiche complete di dati personali plausibili, consentendo ai truffatori di aggirare i controlli bancari e creditizi con il minimo sforzo.

- Manipolazione emotiva: nelle truffe romantiche, i chatbot generati dall'intelligenza artificiale hanno prodotto risposte fluenti ed emotivamente intelligenti in più lingue, consentendo a persone non madrelingua di coinvolgere le vittime in modo convincente e su larga scala .

L'intelligenza artificiale non si limita più ad assistere le frodi, ma le orchestra:

- I criminali possono automatizzare ogni fase dell'operazione, dalla raccolta dei dati alla loro monetizzazione.

- Le campagne fraudolente diventano più scalabili, più adattabili e più difficili da individuare per le vittime (o le banche).

- Anche gli attori meno esperti possono creare servizi fraudolenti che sembrano piattaforme professionali.

Il crescente divario in materia di sicurezza

Ciò che questo rapporto chiarisce è che l'intelligenza artificiale non solo rende gli aggressori più intelligenti, ma anche più veloci e sfuggenti. E questa velocità sta mettendo in luce le lacune nelle attuali misure di sicurezza.

- Gli strumenti tradizionali non riescono a stare al passo. Endpoint , l'autenticazione a più fattori (MFA) e la sicurezza della posta elettronica vengono aggirate, non violate. Gli aggressori utilizzano l'intelligenza artificiale per eludere questi controlli, creando nuove malware , generando phishing o simulando dipendenti che sembrano legittimi.

- Le tempistiche sono ridotte. Un singolo operatore dotato di IA può svolgere il lavoro di un intero team: ricognizione, spostamenti laterali ed estorsioni ora avvengono in poche ore anziché in settimane.

- La complessità non è più sinonimo di sofisticatezza. L'intelligenza artificiale consente anche a soggetti inesperti di generare ransomware avanzati, creare identità sintetiche o mettere in atto frodi su larga scala. Il legame tra competenza tecnica e complessità degli attacchi è ormai spezzato.

Questo è il lacuna nella sicurezza: mentre gli strumenti di prevenzione difendono dalle tecniche conosciute, gli aggressori potenziati dall'intelligenza artificiale sfruttano i punti ciechi che si trovano nel mezzo. E a meno che i team SOC non riescano a vedere i comportamenti che l'intelligenza artificiale non può mascherare (escalation dei privilegi, accessi anomali, movimenti laterali, staging dei dati), la compromissione non viene rilevata.

Colmare il divario con Vectra AI

Per i leader aziendali, la conclusione è semplice: se gli aggressori utilizzano l'IA per ampliare la portata delle violazioni, il vostro SOC ha bisogno dell'IA per ampliare la portata del rilevamento e della risposta. È qui che Vectra AI un valore misurabile.

- Individua ciò che la prevenzione non riesce a rilevare. Che si tratti di ransomware generato dall'intelligenza artificiale, dipendenti fraudolenti o furti di dati nascosti, Vectra AI sui comportamenti degli aggressori che non possono essere nascosti: escalation dei privilegi, movimenti laterali ed esfiltrazione dei dati.

- Copertura ibrida. Gli aggressori non si limitano a un unico canale. Vectra AI contemporaneamente i sistemi di identità, cloud , le applicazioni SaaS e il traffico di rete, eliminando i punti ciechi tra strumenti isolati.

- Priorità basate sull'intelligenza artificiale. Proprio come gli avversari utilizzano l'automazione per accelerare gli attacchi, Vectra utilizza l'intelligenza artificiale per correlare, dare priorità e individuare le minacce più urgenti, in modo che il vostro team possa agire prima su ciò che è più importante.

Il valore aziendale? Si riduce il rischio di perdite finanziarie, sanzioni normative e danni alla reputazione, garantendo al contempo al team di sicurezza la certezza di poter rilevare eventuali compromissioni anche quando gli aggressori utilizzano l'intelligenza artificiale per aggirare i livelli di prevenzione. > Leggi il rapporto IDC sul valore aziendale di Vectra AI.

Sei pronto a scoprire come Vectra AI aiutarti a individuare ciò che agli altri sfugge? Esplora la nostra demo autoguidata e scopri come colmiamo le lacune nella sicurezza.