Le truffe basate sull'intelligenza artificiale spiegate: come funzionano le frodi basate sull'intelligenza artificiale e come le aziende le individuano

Approfondimenti chiave

- Le truffe basate sull'intelligenza artificiale sono aumentate del 1.210% nel 2025, superando di gran lunga la crescita del 195% delle frodi tradizionali, e le perdite previste potrebbero raggiungere i 40 miliardi di dollari entro il 2027.

- Sette diversi tipi di truffe basate sull'intelligenza artificiale prendono ora di mira le aziende, con l'impersonificazione tramite video deepfake, la clonazione vocale basata sull'intelligenza artificiale e il Business Email Compromise (BEC) basato sull'intelligenza artificiale che rappresentano il rischio più elevato per le organizzazioni.

- Le difese tradizionali stanno fallendo. phishing generato dall'intelligenza artificiale phishing gli errori grammaticali, i messaggi generici e le limitazioni manuali su cui i filtri e-mail tradizionali e la formazione sulla consapevolezza facevano affidamento per individuare le frodi.

- Il rilevamento comportamentale colma questa lacuna. Il rilevamento e la risposta di rete (NDR) e il rilevamento e la risposta delle minacce all'identità (ITDR) individuano i modelli anomali di rete, identità e flusso di dati che gli strumenti di sicurezza basati sui contenuti non riescono a rilevare.

- La verifica a più livelli è ora obbligatoria. I controlli finanziari a doppia approvazione, la verifica fuori banda e le frasi di codice pre-condivise riducono il rischio quando qualsiasi singolo canale di comunicazione può essere replicato sinteticamente.

Le frodi basate sull'intelligenza artificiale non sono più un rischio teorico. Solo nel 2024, l'FBI IC3 ha registrato perdite per 16,6 miliardi di dollari a causa dei crimini informatici, con un aumento del 33% rispetto all'anno precedente, e una quota crescente di questi incidenti è stata causata da tecniche di ingegneria sociale potenziate dall'intelligenza artificiale. Una singola videochiamata deepfake è costata alla società di ingegneria Arup 25,6 milioni di dollari. Phishing generato dall'intelligenza artificiale phishing raggiungono ora tassi di clic quattro volte superiori rispetto a quelle create da esseri umani. Secondo il Global Cybersecurity Outlook 2026 del World Economic Forum, nel 2025 il 73% delle organizzazioni è stato direttamente colpito da frodi informatiche.

Questa guida illustra come funzionano le truffe basate sull'intelligenza artificiale, i tipi più comuni riscontrati dai team di sicurezza, i dati più recenti sulle perdite subite e, soprattutto, come le aziende individuano e reagiscono alle frodi basate sull'intelligenza artificiale quando le difese tradizionali non sono sufficienti.

Cosa sono le truffe basate sull'intelligenza artificiale?

Le truffe basate sull'intelligenza artificiale sono schemi fraudolenti che utilizzano l'intelligenza artificiale, inclusi modelli linguistici di grandi dimensioni, clonazione vocale, generazione di video deepfake e agenti autonomi di intelligenza artificiale, per ingannare le vittime su una scala e con una sofisticatezza che prima erano impossibili, eliminando i limiti umani che rendevano il social engineering tradizionale rilevabile e lento.

Mentre le truffe tradizionali dipendevano dall'impegno, dalle competenze linguistiche e dal tempo a disposizione dell'autore, le truffe basate sull'intelligenza artificiale eliminano completamente questi vincoli. L'autore non ha più bisogno di padroneggiare la lingua della vittima, non deve più redigere manualmente messaggi personalizzati e non deve più dedicare ore alla preparazione di un singolo tentativo.

Il Rapporto internazionale sulla sicurezza dell'IA 2026 ha rilevato che gli strumenti di IA utilizzati per queste truffe sono gratuiti, non richiedono competenze tecniche e possono essere utilizzati in modo anonimo. Questa combinazione di fattori (costo zero, competenze zero, responsabilità zero) spiega perché le frodi basate sull'IA stanno crescendo più rapidamente di qualsiasi altra categoria di minacce.

Oltre alle perdite finanziarie dirette, le truffe basate sull'intelligenza artificiale creano un effetto di "decadimento della verità". Man mano che i video deepfake, le voci clonate e i testi generati dall'intelligenza artificiale diventano indistinguibili dalle comunicazioni autentiche, le organizzazioni perdono la capacità di fidarsi di qualsiasi interazione digitale al suo valore nominale. Ogni videochiamata, messaggio vocale ed e-mail diventa sospetto.

In che modo le truffe basate sull'intelligenza artificiale differiscono dalle truffe tradizionali

Il cambiamento fondamentale riguarda la velocità e la qualità su larga scala. Le truffe tradizionali si basavano sullo sforzo umano e presentavano difetti rilevabili: errori ortografici, frasi sconnesse, saluti generici. Le truffe basate sull'intelligenza artificiale raggiungono risultati di qualità umana alla velocità di una macchina.

Consideriamo phishing punto di riferimento. Secondo una ricerca condotta da IBM X-Force, l'intelligenza artificiale è in grado di generare phishing convincente in cinque minuti. Un ricercatore umano impiegherebbe 16 ore per creare manualmente un'e-mail della stessa qualità. Ciò rappresenta un aumento di velocità pari a 192 volte con una qualità equivalente o superiore, il che significa che un singolo aggressore può ora produrre in un giorno ciò che in precedenza richiedeva mesi di lavoro da parte di un team di specialisti.

Le implicazioni si aggravano su larga scala. L'intelligenza artificiale non si limita a eguagliare la qualità umana. Personalizza ogni messaggio utilizzando i dati raccolti dai profili LinkedIn, dai documenti aziendali e dai social media. Uno studio condotto nel 2024 da Brightside AI ha rilevato che phishing generate dall'intelligenza artificiale hanno raggiunto un tasso di clic del 54% rispetto al 12% del phishing tradizionale phishing un moltiplicatore di efficacia pari a 4,5 volte.

Come funzionano le truffe basate sull'intelligenza artificiale

Comprendere il toolkit dell'aggressore è fondamentale per i difensori. Le frodi basate sull'intelligenza artificiale combinano più tecnologie in una catena di attacchi coordinati, in cui ogni fase sfrutta diverse funzionalità dell'IA.

La clonazione vocale rappresenta uno dei vettori di attacco più accessibili. Una ricerca condotta da McAfee ha scoperto che bastano soli tre secondi di audio per creare un clone vocale con un'accuratezza dell'85%. Come riportato da Fortune nel dicembre 2025, la clonazione vocale ha superato la "soglia dell'indistinguibilità", il che significa che gli ascoltatori umani non sono più in grado di distinguere in modo affidabile le voci clonate da quelle autentiche.

La generazione di video deepfake si è evoluta da falsificazioni evidenti ad avatar interattivi in tempo reale. I nuovi modelli mantengono la coerenza temporale senza sfarfallii, distorsioni o artefatti dell'uncanny valley su cui si basavano i precedenti metodi di rilevamento. Il caso Arup ha dimostrato che i partecipanti ai video deepfake possono ingannare professionisti esperti durante le chiamate in diretta.

phishing basato su LLM utilizza modelli linguistici di grandi dimensioni per generare e-mail iper-personalizzate che fanno riferimento a dettagli organizzativi specifici, transazioni recenti e stili di comunicazione individuali. Questi phishing basati sull'intelligenza artificiale non presentano i segni rivelatori che i filtri e-mail tradizionali sono stati addestrati a individuare.

Gli agenti autonomi specializzati nelle truffe rappresentano l'ultima evoluzione. Secondo una ricerca condotta da Group-IB nel 2026, i call center specializzati nelle truffe basati sull'intelligenza artificiale combinano ora voci sintetiche, coaching basato su LLM e risponditori AI inbound per eseguire operazioni di frode completamente automatizzate su larga scala.

La catena di strumenti per le truffe basate sull'intelligenza artificiale

Le catene di strumenti per le truffe basate sull'intelligenza artificiale ora combinano la clonazione vocale, i video deepfake e i modelli di linguaggio generativo (LLM) oscuri in servizi standardizzati che costano meno di un abbonamento a un servizio di streaming.

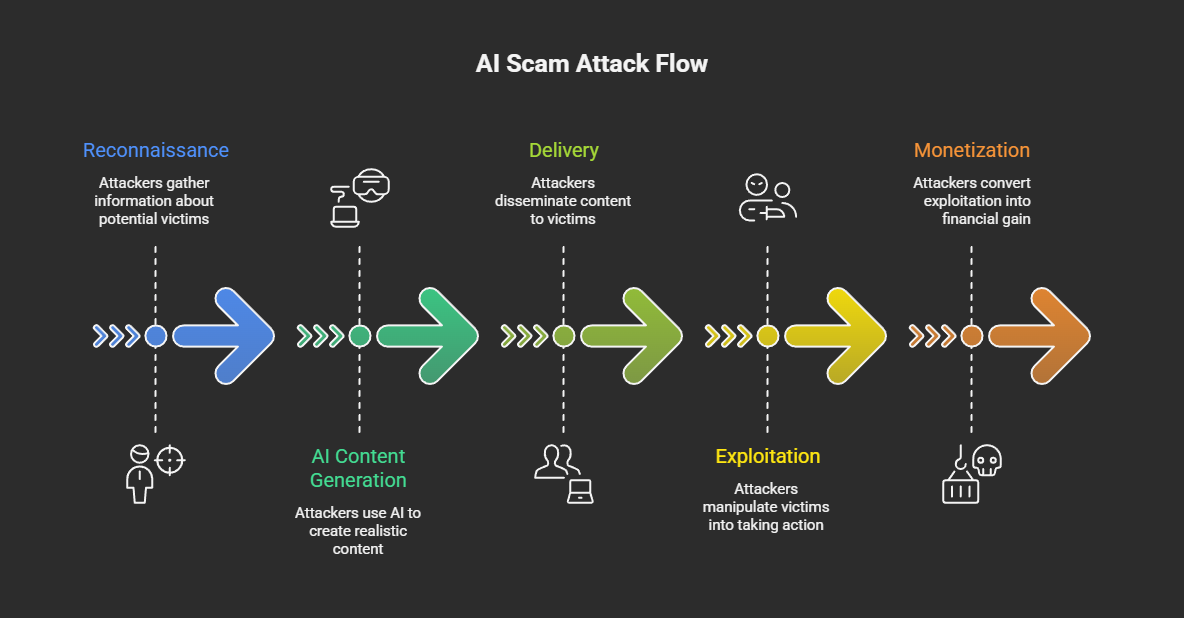

Il tipico attacco di truffa basato sull'intelligenza artificiale segue cinque fasi:

- Ricognizione — Gli aggressori raccolgono dati pubblici (social media, documenti aziendali, registrazioni di conferenze) per creare profili dei bersagli e raccogliere campioni di voce e video.

- Generazione di contenuti AI — Utilizzando LLM oscuri, servizi di clonazione vocale e generatori di deepfake, gli aggressori creano phishing personalizzate, messaggi vocali sintetici o video deepfake.

- Consegna: i contenuti generati dall'intelligenza artificiale raggiungono i destinatari tramite e-mail, telefonate, piattaforme di videoconferenza, app di messaggistica o social media.

- Sfruttamento — Le vittime agiscono sulla base della comunicazione fraudolenta trasferendo fondi, condividendo credenziali, approvando l'accesso o installando applicazioni dannose.

- Monetizzazione — I fondi rubati vengono trasferiti tramite piattaforme di scambio di criptovalute, corrieri di denaro o piattaforme di investimento fraudolente.

L'economia alimenta la crescita. Group-IB ha documentato kit di identità sintetiche disponibili a circa 5 dollari e abbonamenti LLM dark che vanno dai 30 ai 200 dollari al mese. Entro la fine del 2025, si stima che online esistessero otto milioni di deepfake, rispetto ai circa 500.000 del 2023, con una crescita annuale di circa il 900%.

Le barriere all'ingresso sono praticamente scomparse. Chiunque disponga di un accesso a Internet e di un budget limitato può ora lanciare campagne di ingegneria sociale basate sull'intelligenza artificiale che solo cinque anni fa avrebbero richiesto risorse a livello statale.

Tipi di truffe legate all'intelligenza artificiale

Le truffe basate sull'intelligenza artificiale ora coprono sette diversi vettori di attacco, con i video deepfake, la clonazione vocale e il BEC basato sull'intelligenza artificiale che rappresentano il rischio maggiore per le aziende. La seguente tassonomia copre sia le varianti rivolte ai consumatori che quelle rivolte alle aziende.

Tabella: Classificazione dei tipi di truffe basate sull'intelligenza artificiale con valutazione del rischio aziendale. Didascalia: Tipi comuni di truffe basate sull'intelligenza artificiale, metodi di attacco, obiettivi primari, livelli di rischio aziendale e approcci di rilevamento consigliati.

Secondo ScamWatch HQ, nel 2025 le truffe tramite video deepfake sono aumentate del 700%, con Gen Threat Labs che ha rilevato 159.378 casi unici di truffe deepfake solo nel quarto trimestre del 2025. Le varianti aziendali includono l'usurpazione dell'identità di dirigenti in videochiamate (come nel caso Arup), annunci deepfake che impersonano dirigenti finanziari e candidati di lavoro deepfake utilizzati da agenti della Corea del Nord.

Gli attacchi di clonazione vocale e vishing tramite IA superano ormai i 1.000 casi al giorno presso i principali rivenditori. Oltre a prendere di mira i consumatori, gli aggressori utilizzano voci clonate di dirigenti per autorizzare bonifici bancari fraudolenti e impersonare funzionari governativi in campagne di ingegneria sociale.

phishing phishing spear phishing generati dall'intelligenza artificiale hanno raggiunto un punto di svolta. Le analisi di KnowBe4 e SlashNext indicano che l'82,6% delle phishing contiene ora alcuni contenuti generati dall'intelligenza artificiale, mentre Hoxhunt riferisce che il 40% delle e-mail BEC è generato principalmente dall'intelligenza artificiale. La differenza tra queste cifre riflette probabilmente la differenza tra metodologie che prevedono "un qualsiasi tipo di assistenza da parte dell'intelligenza artificiale" e metodologie "interamente generate dall'intelligenza artificiale".

Secondo l'FBI IC3, nel 2024 gli attacchi di tipo Business Email Compromise basati sull'intelligenza artificiale hanno causato perdite per 2,77 miliardi di dollari in 21.442 incidenti. L'intelligenza artificiale sta trasformando i BEC da attacchi basati esclusivamente sulle e-mail a campagne multimodali che combinano e-mail, voce e video per creare imitazioni estremamente convincenti.

Gli investimenti nell'intelligenza artificiale e le truffe sulle criptovalute stanno aumentando rapidamente. L'operazione "Truman Show" di Check Point ha schierato 90 "esperti" generati dall'intelligenza artificiale in gruppi di messaggistica controllati, indirizzando le vittime a installare app mobili con dati di trading controllati dal server. Chainalysis ha riportato perdite per 14 miliardi di dollari dovute a truffe sulle criptovalute nel 2025, con le truffe basate sull'intelligenza artificiale che si sono rivelate 4,5 volte più redditizie delle frodi tradizionali.

Le truffe romantiche basate sull'intelligenza artificiale utilizzano modelli linguistici di grandi dimensioni per mantenere conversazioni emotivamente intelligenti su larga scala. Il rapporto "2026 Future of Fraud Forecast" di Experian identifica i bot emotivamente intelligenti basati sull'intelligenza artificiale come una delle principali minacce emergenti, in grado di sostenere decine di "relazioni" simultanee adattando il tono e la personalità a ciascun bersaglio.

Truffe AI mirate alle imprese

Le organizzazioni devono affrontare una serie concentrata di tipi di truffe basate sull'intelligenza artificiale che sfruttano i rapporti di fiducia e i flussi di lavoro di autorizzazione.

L'usurpazione dell'identità dei dirigenti tramite deepfake prende di mira le transazioni di maggior valore. L'incidente Arup, in cui un dipendente del reparto finanziario è stato ingannato da una videochiamata interamente realizzata con deepfake che includeva l'apparente CFO, con il risultato di 15 transazioni separate per un totale di 25,6 milioni di dollari, rimane il caso più eclatante. È stato scoperto solo grazie alla verifica manuale da parte della sede centrale dell'azienda.

I candidati di lavoro deepfake rappresentano una minaccia emergente e persistente. L'FBI, il Dipartimento di Giustizia e la CISA hanno documentato schemi di lavoratori IT della Corea del Nord che hanno colpito 136 o più aziende statunitensi, con agenti che guadagnano oltre 300.000 dollari all'anno e che sono passati all'estorsione di dati. Gartner prevede che entro il 2028 un profilo candidato su quattro potrebbe essere falso.

phishing spear phishing potenziato dall'intelligenza artificiale phishing larga scala prende di mira interi settori verticali. Brightside AI ha documentato una campagna che ha preso di mira 800 studi contabili con e-mail generate dall'intelligenza artificiale che facevano riferimento a dettagli specifici relativi alla registrazione statale, ottenendo un tasso di clic del 27%, ben al di sopra della media del settore per phishing .

Le truffe legate all'intelligenza artificiale in cifre: statistiche 2024-2026

Le frodi basate sull'intelligenza artificiale sono aumentate del 1.210% nel 2025, con perdite previste che raggiungeranno i 40 miliardi di dollari entro il 2027, poiché gli strumenti di intelligenza artificiale democratizzano l'ingegneria sociale su larga scala.

Tabella: Statistiche relative alle truffe basate sull'intelligenza artificiale e ai deepfake, 2024-2026. Didascalia: Principali metriche relative alle perdite finanziarie, al volume degli attacchi e alla prevalenza delle frodi basate sull'intelligenza artificiale, provenienti da fonti autorevoli.

Nota sull'ambito dei dati: la cifra dell'FBI IC3 (16,6 miliardi di dollari) rappresenta solo le denunce segnalate alle forze dell'ordine statunitensi e deve essere considerata come un valore minimo. La cifra GASA (442 miliardi di dollari) rappresenta una stima globale che include le perdite non segnalate, basata su un sondaggio condotto su 46.000 adulti in 42 paesi. Entrambe sono accurate per le rispettive metodologie e ambiti di applicazione.

Questi numeri corrispondono direttamente alle metriche di sicurezza informatica dell'organizzazione di cui i CISO hanno bisogno per la rendicontazione a livello di consiglio di amministrazione e la giustificazione degli investimenti.

Truffe AI nelle aziende: casi di studio reali

Le perdite causate dalle truffe legate all'intelligenza artificiale aziendale vanno dai 25,6 milioni di dollari di una singola frode deepfake ai miliardi di perdite annuali causate dal BEC, con le frodi informatiche che ora superano il ransomware come principale preoccupazione dei CEO.

Il WEF Global Cybersecurity Outlook 2026 ha rivelato una sorprendente discrepanza nelle priorità: le frodi informatiche hanno superato il ransomware come principale preoccupazione dei CEO nel 2026, ma il ransomware rimane l'obiettivo principale della maggior parte dei CISO. Il 72% dei leader ha identificato le frodi legate all'intelligenza artificiale come una delle principali sfide operative, con l'87% che ha segnalato un aumento delle vulnerabilità legate all'intelligenza artificiale.

Videochiamata deepfake di Arup — 25,6 milioni di dollari

Nel gennaio 2024, un dipendente del reparto finanziario dell'ufficio di Hong Kong di Arup è stato invitato a partecipare a una videochiamata con quello che sembrava essere il direttore finanziario dell'azienda e diversi colleghi. Tutti i partecipanti erano deepfake, generati da filmati di conferenze disponibili al pubblico. Il dipendente ha autorizzato 15 bonifici bancari separati per un totale di 25,6 milioni di dollari (200 milioni di HKD). La frode è stata scoperta solo quando il dipendente ha successivamente verificato con la sede centrale dell'azienda attraverso un canale separato.

Lezione appresa: non ci si può affidare esclusivamente alle videochiamate per l'autorizzazione finanziaria. Le organizzazioni devono implementare controlli di verifica fuori banda e doppia approvazione per le transazioni di alto valore.

Candidati al lavoro deepfake della Corea del Nord

L'FBI ha documentato schemi messi in atto da lavoratori IT della Corea del Nord che hanno colpito almeno 136 aziende statunitensi. Gli agenti utilizzano la tecnologia deepfake per superare i colloqui video, guadagnando poi oltre 300.000 dollari all'anno e convogliando le entrate verso i programmi di armamento della Corea del Nord. Alcuni sono passati all'estorsione di dati, minacciando di divulgare informazioni riservate rubate. Gartner prevede che entro il 2028 un profilo candidato su quattro potrebbe essere falso.

Check Point "Truman Show" frode finanziaria

Nel gennaio 2026, i ricercatori di Check Point hanno scoperto un'operazione che utilizzava 90 "esperti" generati dall'intelligenza artificiale per popolare gruppi di messaggistica controllati. Le vittime venivano indirizzate a installare un'applicazione mobile, disponibile sugli app store ufficiali, che mostrava dati di trading controllati dal server e riportavano rendimenti falsificati. Gli aggressori hanno creato una realtà completamente sintetica per mantenere la frode.

Modelli di targeting specifici per settore

Settori diversi devono affrontare profili di truffe AI distinti. Le organizzazioni di servizi finanziari sono soggette a BEC, frodi telematiche e frodi nei contact center. Un fornitore di servizi sanitari statunitense ha segnalato che oltre il 50% del traffico in entrata era costituito da attacchi guidati da bot. I principali rivenditori riferiscono di ricevere oltre 1.000 chiamate truffaldine generate dall'AI al giorno. Le aziende di tecnologia e di reclutamento di personale IT sono quelle più esposte al rischio di candidati deepfake.

Secondo Cyble, il 30% degli incidenti di furto d'identità aziendale ad alto impatto nel 2025 ha coinvolto deepfake, confermando che i media sintetici generati dall'intelligenza artificiale sono passati dall'essere una novità a diventare una componente fondamentale delle frodi mirate alle imprese. Una pianificazione efficace della risposta agli incidenti deve ora tenere conto di questi vettori di attacco basati sull'intelligenza artificiale.

Rilevare e prevenire le truffe legate all'intelligenza artificiale

La difesa dalle truffe basate sull'intelligenza artificiale aziendale richiede un sistema di rilevamento a più livelli che comprenda analisi comportamentali, monitoraggio delle identità e analisi della rete, poiché i contenuti generati dall'intelligenza artificiale aggirano sempre più spesso i controlli di sicurezza basati sui contenuti.

Ecco un quadro ordinato per la difesa dalle truffe legate all'intelligenza artificiale aziendale:

- Implementare l'analisi comportamentale e l'NDR ( Network Detection and Response ) per identificare modelli di rete anomali associati alle infrastrutture di truffa basate sull'intelligenza artificiale, tra cui comunicazioni di comando e controllo, traffico di sintesi vocale e flussi di dati insoliti.

- Implementare il rilevamento delle minacce all'identità — Il rilevamento e la risposta alle minacce all'identità (ITDR) segnala modelli di autenticazione anomali, richieste di accesso insolite e deviazioni comportamentali che indicano identità compromesse o sintetiche.

- Richiedere controlli di verifica a più livelli — Richiedere la doppia approvazione per le transazioni finanziarie attraverso canali di comunicazione separati. Stabilire frasi di verifica condivise in anticipo per le comunicazioni di emergenza. Verificare tutte le richieste di alto valore attraverso canali fuori banda.

- Migliorare la formazione sulla consapevolezza in materia di sicurezza — Spostare l'attenzione della formazione dall'individuazione degli errori grammaticali al riconoscimento della manipolazione psicologica, dell'urgenza e dei contesti di richieste insolite. La ricerca di IBM sull'ingegneria sociale dell'IA conferma che la tradizionale formazione "individuare gli errori di battitura" è ormai inefficace.

- Implementa una sicurezza della posta elettronica potenziata dall'intelligenza artificiale: utilizza il filtraggio delle e-mail basato sul machine learning che analizza i modelli comportamentali anziché solo le firme dei contenuti. Microsoft Cyber Signals Issue 9 spiega in dettaglio come l'analisi comportamentale rileva ciò che gli strumenti basati sulle firme non riescono a individuare.

- Implementare autenticazione a più fattori ovunque: assicurati che l'autenticazione multifattoriale copra tutti i punti di accesso, con metodi phishing(FIDO2, token hardware) prioritari per gli account con privilegi elevati.

- Accettare i limiti del rilevamento dei deepfake: il rilevamento dei deepfake basato sui contenuti è sempre meno affidabile con il miglioramento della qualità di generazione. Gartner prevede che entro il 2026 il 30% delle aziende riterrà inaffidabili le soluzioni autonome di verifica dell'identità. Il rilevamento comportamentale delle minacce fornisce un livello complementare fondamentale.

MITRE ATT&CK per le minacce di truffe legate all'intelligenza artificiale

La mappatura delle tecniche di frode basate sull'intelligenza artificiale al MITRE ATT&CK aiuta i team GRC e gli architetti della sicurezza a integrare i rischi di frode basati sull'intelligenza artificiale nei modelli di minaccia esistenti.

Tabella: MITRE ATT&CK rilevanti per le truffe basate sull'intelligenza artificiale. Didascalia: mappatura dei metodi di attacco delle truffe basate sull'intelligenza artificiale alle MITRE ATT&CK con indicazioni per il rilevamento.

Panorama normativo in materia di frodi legate all'intelligenza artificiale

Il quadro normativo in materia di frodi legate all'intelligenza artificiale sta diventando sempre più rigoroso.

- Profilo NIST Cyber AI (IR 8596) — Pubblicato il 16 dicembre 2025, questa bozza di quadro normativo affronta tre aree direttamente applicabili alla difesa dalle truffe basate sull'intelligenza artificiale: la protezione dei componenti dei sistemi di intelligenza artificiale, la conduzione di difese informatiche basate sull'intelligenza artificiale e la prevenzione degli attacchi informatici basati sull'intelligenza artificiale (NIST IR 8596).

- Azioni di contrasto della FTC — La FTC ha intrapreso diverse azioni contro schemi fraudolenti basati sull'intelligenza artificiale, tra cui casi che coinvolgono falsi strumenti di investimento basati sull'intelligenza artificiale che hanno truffato i consumatori per almeno 25 milioni di dollari.

- Ordine esecutivo della Casa Bianca sull'IA — L'ordine esecutivo del dicembre 2025 su "Garantire un quadro politico nazionale per l'intelligenza artificiale" istituisce un quadro normativo federale sull'IA e crea una task force per i contenziosi in materia di IA.

- Leggi statali sull'IA — Diverse leggi statali sono entrate in vigore il 1° gennaio 2026, comprese le normative in California e Texas. La legge Colorado S.B. 24-205, che disciplina gli obblighi di governance dell'IA, entrerà in vigore nel giugno 2026.

Approcci moderni alla difesa dalle truffe basate sull'intelligenza artificiale

Il settore sta convergendo su un paradigma di difesa che utilizza l'IA per contrastare l'IA. Gli approcci attuali includono l'analisi comportamentale, il rilevamento delle minacce all'identità, l'analisi del traffico di rete, la sicurezza delle e-mail basata sull'IA, gli strumenti di rilevamento dei deepfake e le piattaforme evolute di formazione sulla consapevolezza della sicurezza.

Diverse tendenze stanno plasmando il panorama. Il rilevamento unificato su rete, cloud, identità e superfici SaaS sta sostituendo gli strumenti isolati che monitorano solo una singola superficie di attacco. I deepfake interattivi in tempo reale presentano sfide che l'analisi statica dei contenuti non è in grado di risolvere. E l'IA agenziale, ovvero i sistemi di IA autonomi che agiscono per conto degli utenti, introduce nuovi vettori di frode in cui le macchine manipolano altre macchine.

I segnali di investimento confermano l'urgenza. Adaptive Security ha raccolto 146,5 milioni di dollari in finanziamenti totali, compreso il primo investimento di OpenAI nella sicurezza informatica, incentrato specificamente sulla difesa dall'ingegneria sociale basata sull'intelligenza artificiale. Il 94% dei leader intervistati dal WEF prevede che l'intelligenza artificiale sarà la forza più significativa nella sicurezza informatica nel 2026.

Date chiave da tenere d'occhio per i difensori: la scadenza per la dichiarazione politica della FTC l'11 marzo 2026; il rapporto annuale previsto dell'FBI IC3 2025 nell'aprile 2026; e l'attuazione del Colorado S.B. 24-205 nel giugno 2026.

Come Vectra AI il rilevamento delle truffe basate sull'intelligenza artificiale

L'approccio Vectra AI si concentra sul rilevamento dei comportamenti della rete e delle identità che indicano che le campagne di truffa basate sull'intelligenza artificiale sono andate oltre la fase iniziale di ingegneria sociale. Monitorando le comunicazioni anomale di comando e controllo, i modelli di autenticazione insoliti e i flussi di esfiltrazione dei dati associati all'infrastruttura di frode basata sull'intelligenza artificiale, Attack Signal Intelligence colma il divario dove le difese basate sui contenuti e il giudizio umano falliscono sempre più spesso contro gli attacchi generati dall'intelligenza artificiale. Ciò corrisponde alla filosofia del "presumere la compromissione": individuare gli aggressori già presenti all'interno dell'ambiente è più affidabile che prevenire ogni tentativo di ingegneria sociale potenziato dall'intelligenza artificiale al perimetro.

Conclusione

Le truffe basate sull'intelligenza artificiale rappresentano la categoria di frodi in più rapida crescita nel campo della sicurezza informatica, grazie a strumenti gratuiti, accessibili e anonimi. I dati sono inequivocabili: crescita del 1.210% delle frodi basate sull'intelligenza artificiale, perdite previste pari a 40 miliardi di dollari entro il 2027 e il 73% delle organizzazioni già colpite.

Le aziende che riescono a difendersi con successo da questa minaccia condividono alcune caratteristiche comuni. Implementano sistemi di rilevamento a più livelli su rete, identità e posta elettronica, anziché affidarsi a un unico controllo. Implementano flussi di lavoro finanziari con doppia approvazione che non si basano su un unico canale di comunicazione. Formano i propri team a riconoscere i modelli di manipolazione psicologica piuttosto che gli errori grammaticali. E accettano la realtà del compromesso: il social engineering generato dall'intelligenza artificiale a volte avrà successo, rendendo il rilevamento e la risposta rapidi fondamentali quanto la prevenzione.

Per i team di sicurezza che valutano il proprio livello di preparazione, il quadro è chiaro. Mappate la vostra esposizione alle truffe basate sull'intelligenza artificiale rispetto alle MITRE ATT&CK documentate sopra. Valutate se il vostro attuale stack di rilevamento copre le anomalie comportamentali della rete, le minacce all'identità e gli attacchi basati sulla posta elettronica. E assicuratevi che i vostri playbook di risposta agli incidenti tengano conto di phishing di deepfake, clonazione vocale e phishing generato dall'intelligenza artificiale.

Scopri come la piattaformaVectra AI rileva i comportamenti della rete e delle identità che indicano campagne di truffa basate sull'intelligenza artificiale, individuando ciò che le difese basate sui contenuti non riescono a rilevare.

Nozioni fondamentali relative alla sicurezza informatica

Domande frequenti

Come si può capire se un video è un deepfake?

Cerca sottili incongruenze nell'illuminazione, nella sincronizzazione labiale e nelle microespressioni facciali, in particolare intorno agli occhi, all'attaccatura dei capelli e alla mascella. Anche errori di sincronizzazione audiovisiva e pattern di battito delle palpebre innaturali possono indicare la presenza di contenuti sintetici. Tuttavia, i modelli deepfake più recenti eliminano sempre più questi artefatti visivi, rendendo l'individuazione basata sui contenuti inaffidabile come approccio autonomo. I responsabili della sicurezza aziendale non dovrebbero affidarsi esclusivamente all'ispezione visiva. I segnali comportamentali sono indicatori più affidabili: richieste insolite, urgenza, transazioni finanziarie e comunicazioni attraverso canali inaspettati. In caso di dubbio, verifica l'identità di qualsiasi partecipante alla videochiamata attraverso un canale di comunicazione separato e prestabilito prima di autorizzare qualsiasi azione. Gartner prevede che entro il 2026 il 30% delle aziende riterrà inaffidabile la verifica dell'identità autonoma.

Cosa fare se sei vittima di una truffa basata sull'intelligenza artificiale?

Per i privati, interrompete immediatamente qualsiasi interazione, contattate la parte oggetto dell'usurpazione di identità tramite un canale verificato già registrato, segnalate l'incidente alla FTC all'indirizzo reportfraud.ftc.gov e all'FBI IC3 all'indirizzo ic3.gov, quindi avvisate il vostro istituto finanziario affinché blocchi tutti i conti interessati. Per le organizzazioni, la risposta deve seguire il piano di risposta agli incidenti: isolare i sistemi interessati, conservare tutte le prove forensi (e-mail, registrazioni delle chiamate, registri delle chat, registri di rete), verificare la portata della compromissione dei sistemi di identità e finanziari e informare le parti interessate secondo il proprio playbook. Documentare le tecniche di IA specifiche utilizzate (video deepfake, voce clonata, e-mail generate dall'IA), poiché queste informazioni aiutano le forze dell'ordine a tracciare i modelli e a costruire i casi.

L'intelligenza artificiale può truffarti al telefono?

Sì. Secondo una ricerca condotta da McAfee, la clonazione vocale tramite IA richiede solo tre secondi di audio per creare una corrispondenza vocale dell'85%. Gli hacker ottengono l'audio da video sui social media, messaggi di benvenuto delle segreterie telefoniche, registrazioni di conferenze e persino brevi conversazioni telefoniche. I principali rivenditori segnalano ora di ricevere più di 1.000 chiamate truffaldine generate dall'intelligenza artificiale al giorno. Secondo l'analisi di Fortune, la clonazione vocale ha superato la "soglia dell'indistinguibilità", il che significa che gli ascoltatori umani non sono in grado di distinguere in modo affidabile le voci clonate da quelle autentiche. Le organizzazioni dovrebbero stabilire procedure di verifica che non si basino mai esclusivamente sul riconoscimento vocale. Utilizzate frasi in codice prestabilite, richiamate tramite numeri verificati in modo indipendente e richiedete una doppia approvazione per qualsiasi transazione finanziaria autorizzata per telefono.

Che cos'è la macellazione dei suini?

Il "macello del maiale" (noto anche come "sha zhu pan") è una truffa finanziaria a lungo termine in cui gli aggressori instaurano un rapporto con la vittima nel corso di settimane o mesi - "ingrassando il maiale" - prima di indirizzarla verso piattaforme di investimento fraudolente. L'intelligenza artificiale ha industrializzato questa truffa attraverso la gestione automatizzata dei profili. L'operazione "Truman Show" di Check Point ha schierato 90 "esperti" generati dall'intelligenza artificiale in gruppi di messaggistica controllati, creando un ambiente sociale interamente sintetico attorno a ciascuna vittima. Le vittime installano app mobili con dati di trading controllati dal server che mostrano rendimenti fittizi. Una volta che le vittime depositano fondi significativi, la piattaforma diventa inaccessibile. I dati di Chainalysis mostrano che le perdite dovute alle truffe sulle criptovalute hanno raggiunto i 14 miliardi di dollari nel 2025, con le operazioni di pig butchering che rappresentano una quota sostanziale.

Come funzionano le truffe romantiche basate sull'intelligenza artificiale?

Le truffe romantiche basate sull'intelligenza artificiale utilizzano modelli linguistici di grandi dimensioni per mantenere conversazioni convincenti ed emotivamente intelligenti su larga scala attraverso piattaforme di incontri e app di messaggistica. A differenza delle truffe romantiche gestite da esseri umani, che richiedono una persona per ogni vittima, l'intelligenza artificiale consente a un singolo operatore di intrattenere decine di relazioni simultanee, ciascuna con stili di comunicazione personalizzati. Il rapporto "2026 Future of Fraud Forecast" di Experian identifica i bot emotivamente intelligenti basati sull'intelligenza artificiale come una delle principali minacce emergenti. Questi bot adattano il tono, la personalità e gli argomenti di conversazione a ciascun bersaglio, imparando le preferenze nel corso del tempo. Le truffe in genere si intensificano passando dalle piattaforme di incontri alla messaggistica privata, per poi introdurre crisi finanziarie inventate o "opportunità" di investimento. Le vittime riferiscono di interazioni che sono sembrate profondamente personali e autentiche nel corso di relazioni durate mesi.

Che cos'è la frode d'identità sintetica?

La frode di identità sintetica utilizza l'intelligenza artificiale per creare identità fittizie combinando dati reali, come numeri di previdenza sociale rubati da violazioni dei dati, con dettagli personali inventati, tra cui volti, indirizzi e storie lavorative generati dall'intelligenza artificiale. A differenza del furto di identità tradizionale, in cui un aggressore assume l'identità di una persona reale, le identità sintetiche rappresentano persone che non esistono, rendendo il rilevamento significativamente più difficile. Group-IB riferisce che kit completi di identità sintetiche sono disponibili a circa 5 dollari. Queste identità sintetiche vengono utilizzate per aprire conti bancari, richiedere crediti, superare verifiche di assunzione e stabilire rapporti commerciali fraudolenti. Gli istituti finanziari sono i più esposti, ma qualsiasi organizzazione che si affidi alla verifica dell'identità durante l'onboarding è a rischio.

L'intelligenza artificiale può creare siti web falsi?

Sì. L'intelligenza artificiale è in grado di generare cloni di siti web convincenti su larga scala, replicando il marchio, i contenuti e le funzionalità dei siti legittimi. Palo Alto Unit 42 ha documentato lo schema "Quantum AI", in cui gli aggressori hanno creato piattaforme di trading false con contenuti generati dall'intelligenza artificiale, completi di dati di performance inventati e testimonianze sintetiche dei clienti. L'operazione "Truman Show" di Check Point ha utilizzato app mobili controllate da server disponibili sugli app store ufficiali. Experian prevede che la clonazione di siti web su larga scala sarà uno dei principali vettori di frode nel 2026. Questi siti falsi sono sempre più difficili da distinguere dalle piattaforme legittime solo attraverso un'ispezione visiva. Le organizzazioni dovrebbero monitorare l'uso non autorizzato del proprio marchio e delle varianti del dominio, mentre gli utenti dovrebbero verificare la legittimità della piattaforma attraverso canali ufficiali prima di inserire credenziali o informazioni finanziarie.